來源:遠川科技評論

作者:陳彬

OpenAI終究還是違背了組訓。

6個月前,OpenAI爆發了一場舉世矚目的內部鬥爭:

CEO奧特曼(Sam Altman)突然被開除,106個小時後,又在員工的簇擁下復職。

自那之後,“刺殺國王”的始作俑者之一、首席科學家伊利亞(Ilya Sutskever),再也沒有現身。伊利亞是“深度學習教父”辛頓的大弟子,OpenAI的靈魂人物。消失前,他最後的工作,是帶領名爲“超級對齊”的安全團隊。

GPT-4o發佈會之後,伊利亞突然更新推文,宣佈從OpenAI離職。首席科學家的退出,加速了OpenAI的分裂。

3天后,另一位“超級對齊”的科學家簡·雷克(Jan Leike),也宣佈提桶跑路。簡·雷克公開爆料稱,兩人與奧特曼等高層存在嚴重分歧,安全團隊舉步維艱。

OpenAI的文化正在“變質”,忽視安全主義而轉向“閃亮的產品”。

陸續有技術大牛選擇離開。

一位OpenAI員工對着媒體說道,“注重安全的員工已經對他失去了信心。信任正一點點崩潰,就像多米諾骨牌一張一張倒下一樣[1]。”

衆所周知,OpenAI是一家由理想主義情結捏合起來的機構。然而,對於如何實現這一理想,OpenAI內部卻漸漸衍生出了兩條不同的路線。伊利亞的離開,意味着他所代表的理想主義,已經徹底敗給了另一種理想主義。

科學家與狂想家

2005年的一個週日,多倫多大學教授辛頓的辦公室門外,來了個不速之客。

來者是一位數學系的學生,操着一口東歐口音,表情似乎總是愁眉苦臉。彼時,辛頓是極少數仍在研究深度學習的學者,並在多倫多大學組建了一個實驗室。

這個學生說,他整個夏天都在快餐店兼職炸薯條,現在他更想來這個實驗室工作。

辛頓打算考考這位急於展現自己的年輕人,給了他一份反向傳播的論文。這篇論文寫於上世紀80年代,是辛頓最知名的研究成果之一。幾天後,這個學生回來了,問他,“你爲什麼不求導並採用一個合理的函數優化器?”

辛頓倒吸了一口氣,“我花了5年時間才想到這一點。[2]”這個學生,就是伊利亞。

辛頓發現,伊利亞有種非常強大的原始直覺,能靠“第六感”找到正確的技術路線[2]。因此,辛頓將伊利亞視作唯一一個比自己更“天才”的學生[3]。

並且,辛頓很快發現,“技術天才”只是伊利亞身上的一個特質。

與伊利亞長期共事過的研究員謝爾蓋·萊文(Sergey Levine)曾說道,他喜歡大的想法,並且從不懼怕相信。“不怕的人有很多,但他尤其不怕。[2]”

2010年,伊利亞在閱讀了一篇論文之後,便大膽宣稱,深度學習將改變計算機視覺——只需要有人來推動這項研究。在那個深度學習等同於民科的時代,伊利亞這番發言,顯然是有些倒反天罡的。

然而,他只花了2年,就打了所有人的臉。

2012年,辛頓、伊利亞以及克里哲夫斯基三人打造的AlexNet,以高達84%的圖像識別正確率,讓世界看到了深度學習的潛力,並引發了產業界的狂熱追逐。

那一年,谷歌花了4400萬美元的天價,只爲了將AlexNet的3位作者收入麾下。

谷歌工作期間,伊利亞又開始相信一件更宏大的事情:超越人類的超級智能,已經近在眼前。

一方面,是因爲他發現深度學習的遊戲規則變了。

此前,研究深度學習的只有一小撮人,資源捉襟見肘。2009年時,辛頓曾短暫地在微軟做過一個深度學習項目,連一張價值1萬美金的顯卡都申請不下來,氣得他一頓陰陽怪氣,“微軟顯然是家資金短缺的軟件銷售商。[2]”

然而,自AlexNet之後,無數聰明頭腦與熱錢湧入,未來被加速了。

另一方面,早在學生時期,伊利亞就堅信Scaling laws。“第六感”告訴他,超級智能並沒那麼複雜,只需要更多的數據與算力。

並且,伊利亞又一次證明了自己是對的。

2014年的NIPS學術會議上,伊利亞公佈了他最新的研究成果:Seq2Seq(序列到序列)模型。Transformer誕生之前,它曾是谷歌機器翻譯的靈魂。只需要足夠的數據,Seq2Seq模型就能表現得很好。

伊利亞在路演中提到,一個弱模型永遠不可能有好的表現。“真正的結論是,如果你有一個非常大的數據集和非常大的神經網絡,那麼成功是有保證的。[4]”

科學家與狂想家這兩張面孔,在伊利亞身上迸發了神奇的化學反應。

隨着伊利亞對超級智能愈發篤信,他對安全問題的重視也與日俱增。沒過多久,伊利亞便遇見了知己。

理想主義的天花板

2015年,伊利亞收到投資機構Y Combinator掌門人薩姆·奧特曼的邀請,前往硅谷的瑰麗酒店參與一場祕密聚會。然而,奧特曼並非這場祕密聚會的主角。

馬斯克突然現身,告訴現場所有人,他打算成立一間AI實驗室。

促使馬斯克這麼做的導火索,是數週前的44歲生日派對。

當時,馬斯克邀請了谷歌CEO拉里·佩奇等一衆好友,去度假村玩了3天。晚飯過後,馬斯克與佩奇圍繞AI展開了激烈爭吵。馬斯克認爲AI會毀滅人類,而佩奇則不以爲然,嘲諷他是個“物種主義者”,對硅基生命有偏見[5]。

從那之後,馬斯克就不怎麼和佩奇說話了。

在祕密聚會的現場,馬斯克等人提到,很少有科學家會考慮自己研究的長期後果。如果任由谷歌這樣的大型企業壟斷AI技術,很可能會在無意間造成巨大傷害。

因此,他們提出了一種全新的形式:

成立一間不受任何人控制、非盈利的實驗室。

他們同樣會去追逐AGI(通用人工智能)的聖盃,但不以盈利爲導向,且放棄大多數研究成果,轉而面向社會公開(open source)。馬斯克與奧特曼認爲,如果所有人都能獲得強大的AI,那麼“惡意AI”的威脅將大大降低。

“我能想到最好的事情,就是讓人類以更安全的方式構建真正的AI。”另一位組織者布羅克曼(Greg Brockman)說道[6]。

伊利亞被這個浪漫的想法打動了。他爲此放棄了年薪200萬美元的誘惑,毅然加入OpenAI。

成立的頭15個月,OpenAI並沒有設立具體的戰略方向。谷歌科學家達里奧·阿莫迪(Dario Amodei),當時曾拜訪過OpenAI,詢問在研究什麼,OpenAI的管理層竟一時答不上來,“我們現在的目標...是做點好事。[7]”

幾個月後,阿莫迪跳槽去了OpenAI,一起做點好事。

2017年3月,奧特曼等領導層意識到該更專注了。然而,在規劃AGI路線圖的時候,他們卻發現了一個嚴重的問題:算力跟不上了。大模型所需要的算力,每隔3-4個月就會翻一倍;非盈利機構的形式,顯然不足以支撐。

當時,馬斯克提出了一個提案:OpenAI併入特斯拉,由他完全掌管[8]。

然而,馬斯克低估了奧特曼的野心。

奧特曼一直在尋找重大的科學突破,希望憑此打造出一家價值萬億美金的企業。過去,YC最爲人熟知的投資案例,是Airbnb。隨着奧特曼掌權之後,YC開始擠破腦袋尋找各種研究核聚變、人工智能、量子計算的公司。

a16z創始人、風險投資家馬克·安德森曾表示,“在奧特曼的領導下,YC的野心水平提高了10倍。[9]”

2018年2月,奧特曼將OpenAI管理層都拉攏到了自己的陣營。馬斯克從此離開了團隊,不再和奧特曼說話,並取消了對OpenAI的後續資助。

兩個月後,奧特曼發佈了OpenAI的公司章程。在不起眼的角落,他對公司願景的表述,做了些小小的修改,“我們預計需要調動大量資源來完成使命。”

至此,曾經那個高度理想主義的OpenAI,漸漸踏入了另一條河流。

第一次分裂

2019年2月,OpenAI對外宣告了GPT-2,卻沒有第一時間對外開源。而後來的GPT-3,更徹底走向了閉源,OpenAI變成了CloseAI。

一個月後,OpenAI又改變了“非盈利”的性質,成立了一個營利部門,並接受了微軟10億美金的投資。

突然的180度大轉向,使得OpenAI內部開始分裂成兩個對立的派別:

以達里奧·阿莫迪、伊利亞爲代表的安全主義,認爲必須先確保AI不會威脅人類,再公開發布產品;

而以奧特曼、布羅克曼爲代表的加速主義,則希望加速AI的普及,從而讓更多人使用AI造福世界。

從中可以看出,兩個派別的行事方式完全相反:

安全主義主張先驗證安全,再發布;而加速主義主張先擴大市場,再根據測試結果與反饋進行調整。

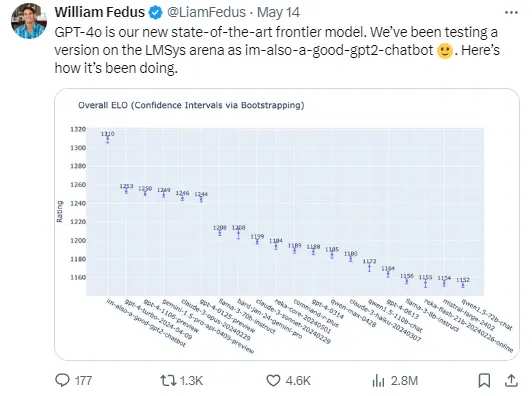

前些日子發佈的GPT-4o,就是典型的加速主義做派。發佈會之前,OpenAI匿名發佈了性能強大的模型“im-also-a-good-gpt2-chatbot”,引起了開發者社區的廣泛猜測與討論。

事後證明,這模型就是GPT-4o的前身;而奧特曼故弄玄虛的目的,正是想讓吃瓜群衆幫他做測試。

隨着分歧加劇,2021年,安全主義者、曾想一起做點好事的達里奧·阿莫迪,引發了OpenAI的第一次分裂。他認爲,OpenAI正從“勇者”變成“惡龍”,越來越商業化,忽視了安全主義。

於是,他帶領着一批覈心員工出走,成立了另一家AI公司Anthropic。

阿莫迪將Anthropic定位成一家公益公司,這將使他們能夠同時追求商業利潤和社會責任。如今,Anthropic已成爲OpenAI最大的競爭對手。

達里奧·阿莫迪的離職,在OpenAI內部造成了巨大動盪,但奧特曼仍試着努力維持兩個派別的平衡。

直到ChatGPT的發佈。

一種理想主義的失敗

ChatGPT是個臨時項目。

當時,OpenAI正全力開發GPT-4。然而,有傳聞稱,阿莫迪的Anthropic正在開發聊天機器人。於是,奧特曼臨時指派員工,給現有的GPT-3.5也打造一個聊天界面。奧特曼將ChatGPT稱爲“低調的研究預覽”,可以幫助OpenAI收集人類與AI交互的數據。

當時,OpenAI內部員工搞了個賭注池,猜1周內能獲得多少用戶,最大膽的賭注是10萬人[11]。

最終成績是100萬。

2個月後,這個“低調的研究預覽”,成爲了歷史上最快突破1億用戶的應用程序。

兩個派別的平衡被徹底打破了。

一位內部員工對媒體說道,“ChatGPT誕生後,OpenAI有了獲取收入的明確途徑。你不能再用‘理想主義的實驗室’標榜自己了,現在就有顧客希望得到服務。[12]”

從學生時代開始,伊利亞就相信超級智能並不遙遠。隨着ChatGPT引發行業追逐,他對安全的焦慮變重了,與其他加速主義管理層的矛盾也日趨嚴重。

有人覺得他越來越神神叨叨,也有人覺得他開始更像一位精神領袖了。

2022年OpenAI的節日派對上,伊利亞開始帶着所有員工高喊,“feel the AGI(感受AGI)”。在其他許多不同場合,他也反覆說過這句話——彷彿超級智能已經近在咫尺。

去年宮鬥之前,伊利亞曾告訴一位記者,ChatGPT可能是有意識的,世界需要認識到這項技術真正的力量。

這位媒體同志不止見過伊利亞一次,對他的印象並不算好:每次見面,他都會說很多極其瘋狂的話[13]。

2023年7月,伊利亞啓動了“超級對齊”項目,發起了對加速主義的最後反抗。

在AI語境中,對齊(Alignment)並非某種黑話,而是一個專業術語,指讓前沿的AI系統與人類的意圖、價值觀對齊。然而,伊利亞認爲,超級智能的智慧程度將遠超人類,人類智慧已經不足以拿來當衡量的標準。

他提到,當年的AlphaGo是個典型的例子。

它與李世石第二盤棋的第37手,下在了一個所有人都沒想到的位置。當時,連中國圍棋國手羋昱廷都在解說臺上驚呼,“這是什麼鬼,沒擺錯嗎?”事後看來,這手棋恰恰是奠定AlphaGo勝局的關鍵。

連AlphaGo都如此捉摸不透,更遑論即將到來的超級智能。

因此,伊利亞拉上同事簡·雷克,成立了“超級對齊”團隊。工作內容很簡單:在4年之內打造一個強大的AI系統,讓它代替人類智慧負責對齊工作,而OpenAI將爲這個項目提供20%的算力。

只可惜,奧特曼並沒有給安全主義反抗的機會,沒有兌現20%算力的承諾。

去年年底,伊利亞射出的最後一顆子彈,也未能擊中要害。當伊利亞未能成功“刺殺國王”,他與OpenAI的結局就已經註定了。

尾聲

GPT-4o發佈之後,奧特曼重申了修改後的公司願景:

OpenAI使命的一部分,是將非常強大的AI工具免費(或以優惠的價格)提供給人們。他在博客中寫道,“我們是一家企業,很多東西需要收費,這將有助於我們向數十億人(希望如此)提供免費、出色的AI服務。[15]”

2016年時,《紐約客》曾發佈了一篇關於奧特曼的特稿。

當時,奧特曼最主要的身份,還是YC的掌門人。實際採訪時,《紐約客》記者在奧特曼身上感受到了一種侵略性。

“他正在硅谷內迅速建立起一種新的經濟,這種經濟似乎旨在取代原本的硅谷。[9]”

如今,隨着OpenAI徹底告別伊利亞時代,奧特曼將繼續完成當年未竟的野心。

參考資料

[1] “I lost trust”: Why the OpenAI team in charge of safeguarding humanity imploded,Vox

[2] Geoffrey Hinton | On working with Ilya, choosing problems, and the power of intuition,Sana

[3] 深度學習革命,凱德·梅茨

[4] NIPS: Oral Session 4 - Ilya Sutskever,Microsoft Research

[5] Ego, Fear and Money: How the A.I. Fuse Was Lit,New York Times

[6] Inside OpenAI, Elon Musk's Wild Plan to Set Artificial Intelligence Free,Wired

[7] The messy, secretive reality behind OpenAI’s bid to save the world,MIT Technology Review

[8] The secret history of Elon Musk, Sam Altman, and OpenAI,Semafor

[9] Sam Altman’s Manifest Destiny,The New Yorker

[10] AI researchers debate the ethics of sharing potentially harmful programs,The Verge

[11] Inside the White-Hot Center of A.I. Doomerism,New York Times

[12] Inside the Chaos at OpenAI,The Atlantic

[13] Rogue superintelligence and merging with machines: Inside the mind of OpenAI’s chief scientist,MIT Technology Review

[14] OpenAI Wants to Harness AI. It Should Pause Instead,The Information

[15] GPT-4o,Sam Altman

編輯/Somer