AI PC包括优化版的OpenVino和DirectML,可在CPU、GPU和NPU上高效运行例如Phi-3这样的生成式AI模型。部署能够推理并使用工具采取行动的AI代理,在AI PC上高效运行AI模型,利用推测解码和量化技术,适用于多种用例,如个人助手、安全本地聊天、代码生成、检索增强生成(Retrieval Augmented Generation,RAG)等等。

微软年度Build开发者大会周二来袭,英特尔主体软件架构师Saurabh Tangri和AI应用研究团队主管Guy Boudoukh介绍了AI PC的发展情况和应用趋势。

Tangri介绍,AI代理和生成式AI应用程序为PC用户提供了无与伦比的能力。AI PC包括优化版的OpenVino和DirectML,可在CPU、GPU和NPU上高效运行例如Phi-3这样的生成式AI模型。部署能够推理并使用工具采取行动的AI Agents,在AI PC上高效运行AI模型,利用推测解码和量化技术,适用于多种用例,如个人助手、安全本地聊天、代码生成、检索增强生成(Retrieval Augmented Generation,RAG)等等。

Tangri表示,目前的AI技术已经可以将一些功能内置于平台中。他表示,当用户有在静态数据库进行训练的静态的语言模型时,需要有同时运行这些模型的能力,目前可以通过运行检索增强生成(RAG) 来增强其能力,从而增强AI执行更多任务的能力。

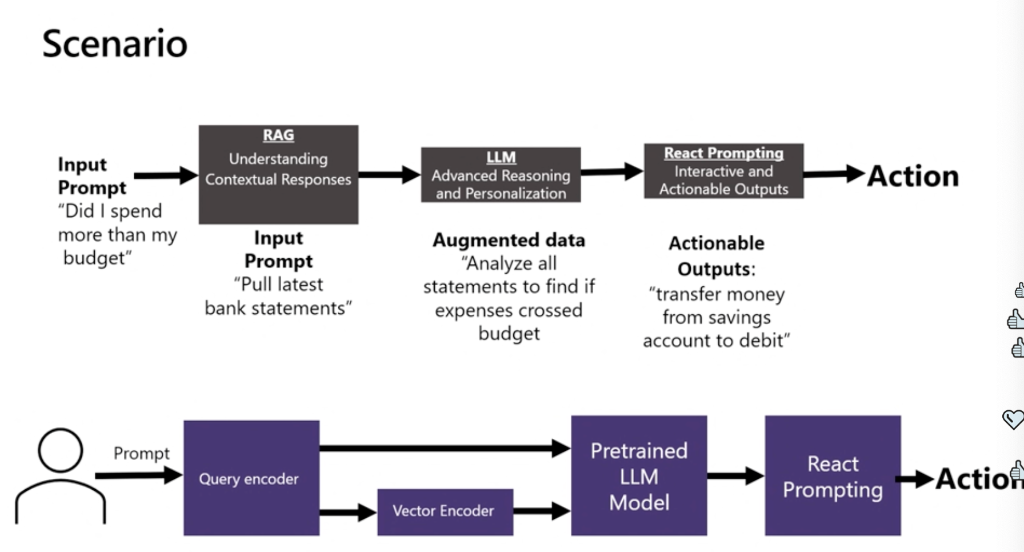

他举例说,在一个消费者场景,你经常会遇到的问题是“我是否超出了预算”。现在你可以通过AI引入你的私有数据,使用先进的LLM(大型语言模型)进行分析,你可以沿这些线路放置一些内容,然后你就能够从中提取一些结论和行动。

“这一元素非常新颖。我对此非常兴奋,这是我们首次展示这一完整管道,从RAG到LLM再到反应、推理,全部在你的PC上运行。这非常有趣,非常前沿。”

Guy Boudoukh随后演示了利用由英特尔Core Ultra处理器驱动的多模态小模型Phi-3,包括Phi-3AI代理的响应、与私人数据的交流、用户如何与文档对话并通过RAG来生成答案等。

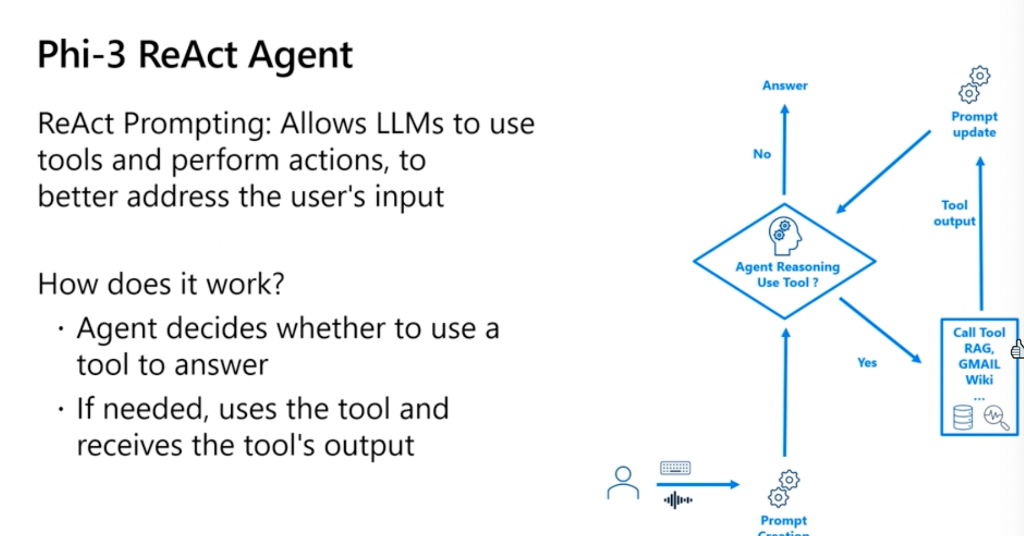

Boudoukh介绍,Phi-3 ReAct代理前端是用户向语言模型提供的指令和上下文,以实现所需任务,这可以是聊天或问答。他介绍,ReAct提示去年由普林斯顿大学和谷歌首次引入,这是一种新的提示方法,ReAct代表推理和执行。

他说,这种方法允许LLM不止做简单的文本生成,它实际上允许LLM使用工具并执行操作,以更好地处理用户的输入。它允许LLM结合各种工具,如RAG、Gmail、维基百科、必应搜索等,其中一些工具可以访问设备上的私有数据,而一些工具可以访问互联网。

首先可将用户查询输入到ReAct模板中,然后将其注入Phi-3代理,代理决定是否需要使用工具来回答用户查询。如果需要工具,则调用工具,然后将工具的输出返回给提示对话框,然后再次返回给代理。代理可以决定是否需要使用另一个工具来回答这个问题,这个过程会再次重复。只有当代理认定,有足够的信息来回答用户查询时,它才会生成答案。

在演示中,Boudoukh询问今年有多少队伍参加了欧冠,代理进行了推理并理解,需要RAG来回答这个问题,于是搜索了160篇BBC体育新闻;然后他要求代理通过Gmail发送这个答案,因此代理就调用了另一个工具Gmail来解决这一问题。

随后,Boudoukh演示了Phi-3代理执行RAG的具体过程。他说,RAG允许LLM通过注入检索到的信息来访问外部知识。首先,用户在设备上索引数百甚至数千个文件,这些文件将嵌入索引并保存到一个向量数据库(Vector DB)中。现在,一旦用户提供查询,从数据库中检索信息,并创建一个由用户查询和检索信息组成的新统一提示,然后将这个提示注入LLM并生成答案。

他说,RAG有几个优势。首先,它增强了LLM的知识,而不需要训练模型。其次,这样的数据使用非常高效,因为不需要提供整个文档,只需要提供检索到的信息。这减少了模型的幻想并提高了可靠性,因为在提供答案时,它会参考获取答案的相关数据。

在随后的演示中,Boudoukh跳过代理,直接询问机器今年有多少队伍参加了欧冠,他首先并未使用RAG,结果代理生成了错误的答案,回答说今年有32支队伍,但实际上今年有36支队伍参赛。然后他调用RAG询问同一问题,就得出了正确的答案。

Boudoukh表示,这可以向开发者展示,如何利用软件栈在NPU、CPU和集成GPU之间分配工作。例如,这里的语音识别模型Whisper是在NPU上运行的,Phi-3推理则在集成GPU上运行,而数据库搜索则在CPU上运行。

最后Boudoukh进行了LLaVA Phi3多模态模型演示。他介绍,该模型是经过视觉和颜色训练的,因此可以处理涉及文本和图像的多模态任务。他将一张图像插入模型,并要求模型描述图像场景,模型则给出了对场景的详细理解,甚至建议在这里钓鱼放松。

他还展示了模型代码的核心部分之一,即LLM推理部分。他说,要在英特尔Core Ultra处理器上运行Phi-3和LLM推理很容易,只需要定义模型的名称,定义量化配置、加载模型、加载标记器(tokenizer),然后提供一些示例,进行标记操作,对输入进行标记,然后生成结果。而这一演示利用的优化版的OpenVino,即AI PC的一种。

Tangri表示,这就是AI PC与LLM共同运行的精彩表现。现实世界中的AI有四个支柱:效率、安全性、与网络协作的能力,以及开发者准备度。如果你拥有前三者,但没有为开发者做好准备,你将无法在这个平台上进行创新。

他表示,高效率指的是能够延长设备的电池寿命,而不只是追求高每秒浮点运算次数(TeraFLOPS)的假象。“归根结底,我们真正追求的是客户体验和用户体验,这涉及到将自然语言界面与图形用户界面结合起来。所以,最终,我们追求的是体验,而不是虚假的性能指标。”

Tangri表示,英特尔过去几年来已经和微软合作创立标准,如开放神经网络交换ONNX(Open Neural Network Exchange)的标准。而关于开发者的准备度,他表示,英特尔目前有一个前沿的尖端研究的运行演示,可以完全在PC环境中运行。“所以我们真正迎合了开发者的需求,降低了在我们的平台上创新的门槛,无需在线上和云端使用,这一切都可以在你的PC上完成。”