(圖片來源:Apple官網)

蘋果公司突然公佈了一則大新聞。

北京時間4月25日凌晨,蘋果在 Hugging Face 平台上發佈一個“具有開源訓練和推理框架的高效語言模型”,名爲 OpenELM。

據了解,OpenELM有四種尺寸:2.7億、4.5億、11億和30億個參數版本,定位於超小規模模型,而微軟Phi-3模型爲38億。這種小模型運行成本更低,可在手機和筆記本電腦等設備上運行。

同時,在WWDC24開發者大會之前,蘋果徹底開源了OpenELM模型權重和推理代碼,數據集和訓練日誌等。而且,蘋果還開源了神經網絡庫CoreNet。

早在今年2月,蘋果公司CEO蒂姆·庫克(TimCook)就表示,蘋果生成式 AI 功能將於“今年晚些時候”推出,有消息稱即將在6月發佈iOS 18可能是蘋果iOS史上“最大”的更新,而9月也將推出首款AI iPhone設備。

如今,蘋果似乎在新一輪AI浪潮快到尾聲的時刻追趕上了行業腳步。

預訓練tokens數量減一半,11億參數蘋果模型效果卻比競品更精準

隨着ChatGPT風靡全球,近幾個月來,三星、谷歌、小米等手機廠商全面推進大語言模型在手機、平板等端側上的使用,包括照片處理、文字處理增強等,並形成一大賣點。而蘋果很少透露並極少有類似的自帶功能,主要是用第三方工具做到類似效果。

今年2月業績會議上,庫克首次公佈生成式 AI 計劃,並將在今年晚些時候將 AI 技術集成到其軟件平台(iOS、iPadOS 和 macOS)中。

庫克表示,“我只想說,我認爲蘋果在生成式 AI 和 AI 方面存在着巨大的機會,無需透露更多細節,也無需超出自己的預期。展望未來,我們將繼續投資於這些和其他將塑造未來的技術。其中包括 AI,我們繼續在 AI 領域花費大量時間和精力,我們很高興能在今年晚些時候分享我們在該領域正在進行的工作的細節。我們對此非常興奮。”

實際上,自年初至今,蘋果在生成式 AI 領域動作不斷。今年3月,蘋果技術團隊發表論文《MM1: Methods, Analysis & Insights from Multimodal LLM Pre-training》,首次披露蘋果大模型MM1,涵蓋300億參數、支持多模態、支持MoE架構,超半數作者屬於華人。

如今,針對手機、平板等端側領域,蘋果真正的開源模型終於來了。

據論文顯示,蘋果開源了大語言模型OpenELM,有指令微調和預訓練兩種模型版本,共有2.7億、4.5億、11億和30億4種參數,提供生成文本、代碼、翻譯、總結摘要等功能。

雖然最小的參數只有2.7億,但蘋果使用了包括RefinedWeb、去重的PILE、RedPajama的子集和Dolma v1.6的子集在內的公共數據集,一共約1.8萬億tokens數據進行了預訓練,這也是其能以小參數表現出超強性能的主要原因之一。

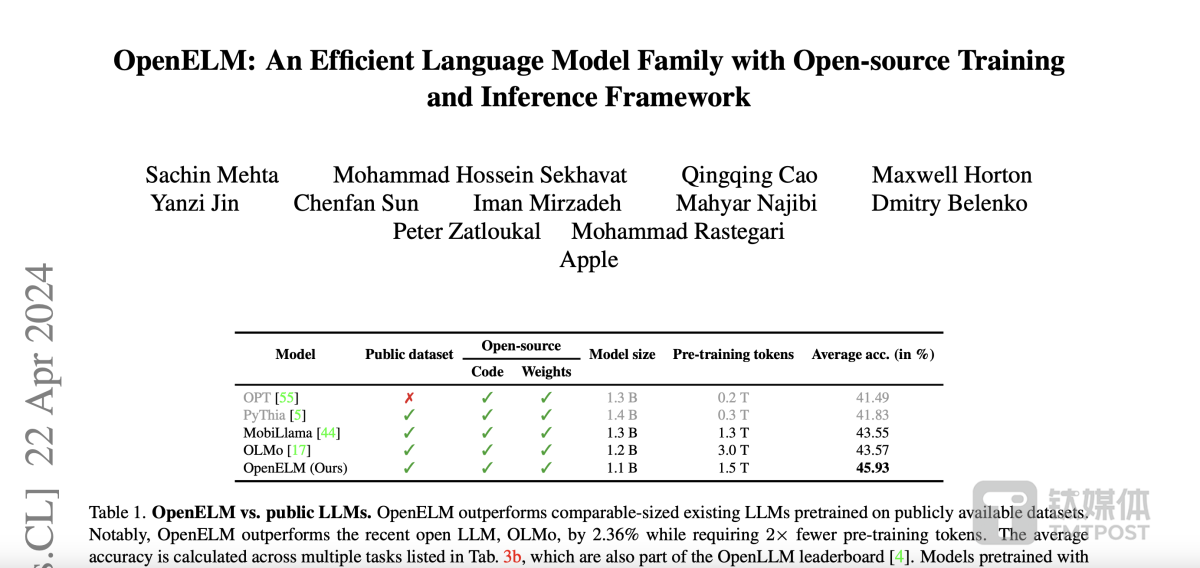

例如,11億參數的OpenELM,比12億參數的OLMo模型的準確率高出2.36%,而使用的預訓練數據卻只有OLMo的一半。

在訓練流程中,蘋果採用了CoreNet作爲訓練框架,並使用了Adam優化算法進行了35萬次迭代訓練。而蘋果的MobileOne、CVNets、MobileViT、FastVit等知名研究都是基於CoreNet完成的。

蘋果在論文中還表示,與以往只提供模型權重和推理代碼並在私有數據集上進行預訓練的做法不同,蘋果發佈的版本包含了在公開數據集上訓練和評估語言模型的完整框架,包括訓練日誌、多個檢查點和預訓練配置。同時,蘋果還發布將模型轉換爲 MLX 庫的代碼,以便在蘋果設備上進行推理和微調。

“此次全面發佈旨在增強和鞏固開放研究社區,爲未來的開放研究工作鋪平道路。”蘋果研究團隊表示。

此外,OpenELM不使用任何全連接層中的可學習偏置參數,採用RMSNorm進行預歸一化,並使用旋轉位置嵌入編碼位置信息。OpenELM還通過分組查詢注意力代替多頭注意力,用SwiGLU FFN替換了傳統的前饋網絡,並使用了Flash注意力來計算縮放點積注意力,能以更少的資源來進行訓練和推理。同,蘋果使用了動態分詞和數據過濾的方法,實現了實時過濾和分詞,從而簡化了實驗流程並提高了靈活性。還使用了與Meta的Llama相同的分詞器,以確保實驗的一致性。

這次,蘋果很有誠意將代碼開源,一開到底,把所有內容都貢獻出來了。僅1天多的時間,該模型GitHub平台上就獲得超過1100顆星。

而目前,大模型領域主要分爲開源和閉源兩大陣營,國內外知名閉源的代表企業有OpenAI、Anthropic、谷歌、Midjourney、百度、出門問問等;開源陣營有Meta、微軟、谷歌、商湯、百川智能、零一萬物等。

蘋果作爲手機閉源領域的領導者,此次卻罕見地加入開源大模型陣營。有分析認爲,這可能在效仿谷歌的方式先通過開源拉攏用戶,再用閉源產品去實現商業化營利。

同時,這也表明蘋果進軍 AI 大模型領域的堅定決心。

作爲同爲端側模型、開源模型企業,商湯科技聯合創始人、首席科學家王曉剛近期對鈦媒體App表示,開源還是對於整個社區的發展還是非常重要的,是一個重要驅動力。最終大模型的發展包括各種應用,還是要整個社區共同去推動的。對於大模型的應用也分爲不同的層次,這麼多行業對應用的需求也是不一樣的,豐富的開源社區非常重要。

AI 技術持續“狂飆”,OpenAI獲得了全球第一塊DGX H200

不止是蘋果,今天凌晨,國內外 AI 技術依然“狂飆”,相關消息滿天飛。

今晨,OpenAI聯合創始人、COO Greg Brockman發推文表示,英偉達向該公司移交全球範圍內第一塊DGX H200,此舉旨在“推進人工智能、計算技術與人類的發展”。

同時,他也發佈了一張合影,還包括英偉達CEO黃仁勳、OpenAI CEO奧爾特曼(Sam Altman),看起來三人非常開心。

早在2016年,OpenAI剛成立不久,黃仁勳便親自將全球首臺裝備了8塊英偉達P100芯片的超級計算機DGX-1送到了OpenAI的辦公室。

這臺價值逾百萬美元的DGX-1,是黃仁勳帶領英偉達3000名員工,歷時三年精心打造的成果。它極大地提升了OpenAI的計算能力,將原本需要一年的訓練時間縮短至僅一個月。

當時,OpenAI還處於一個初創階段的非營利機構,這臺超級計算機無疑是一份極具分量的禮物。馬斯克、Sam Altman以及其他早期員工對此感到無比激動,紛紛在這臺DGX-1上留下了自己的簽名。

2023年11月13日,英偉達發佈了新一代AI GPU——NVIDIA Grace Hopper H200超級芯片,其內存容量和帶寬分別是H100的兩倍和1.4倍,最高支持19.5TB,AI 性能達128 petaFLOPS FP8,預計2024年第二季度開始供貨。

黃仁勳稱,這是擁有萬億規模的新型 AI 超級計算機,爲巨型 AI 模型提供具有線性可擴展性的海量共享內存空間,能夠在生成式 AI 時代發揮巨大潛力。

如今,黃仁勳親手將全球第一塊DGX H200送給了OpenAI。

同時,據CTech報道,英偉達以約7億美元收購了以色列AI基礎設施編排和管理服務Run:ai,據悉,Run:ai成立於2018 年,迄今已籌集1.18億美元,同時英偉達還收購了Deci公司。

另外,今天凌晨,擁有全球首個 AI 代碼工程師的背後企業Cognition被曝完成了一輪1.75億美元的融資,由Founders Fund 領投,僅僅一個月內,公司估值從3.5億美元增長到20億美元,引發關注。

Gartner分析師John-David Lovelock表示,隨着Anthropic、OpenAI 等第一梯隊的玩家佔據主導地位,AI投資範圍正在“向外延展”(spreading out)。

“數十億美元的投資數量已經放緩,而且幾乎已經結束;熱錢湧向了新方向——AI 應用。”上述分析師表示,“大模型需要大量投資,但市場現在更多地受到科技公司的影響,這些公司將利用現有的 AI 產品、服務和產品來構建新產品。”

Greylock合夥人Seth Rosenberg認爲,人們對於資助AI領域的“大批新玩家”的興趣本來就較很小。在這個週期的早期階段,投資基礎模型資本非常密集,相比之下,AI 應用和智能體所需的資本較低,這可能是絕對美元融資額下降的原因。

Thomvest Ventures 董事總經理 Umesh Padval 將 AI整體投資的縮減,歸因於增長低於預期。他表示,最初的熱情已經讓位於現實—— AI 面臨一部分技術挑戰,一部分上市挑戰,可能需要數年時間才能解決並完全克服。

”AI 投資放緩反映出人們認識到,我們仍在探索 AI 技術發展及其在各行業應用的早期階段。雖然長期市場潛力仍然巨大,但最初的熱情已被在實際應用中推廣 AI 技術的複雜性和挑戰所削弱……這表明投資環境更加成熟和敏銳。“Umesh Padval表示。

如今,AI 持續“狂飆”,但整個市場方向已快速轉變,端側模型、AI 應用、行業大模型等都將成爲今年整個 AI 領域新趨勢。

(本文首發於鈦媒體App,作者|林志佳,編輯|胡潤峯)